|

|

Правило настройки смещенийОдно из ограничений всякого конкурирующего слоя состоит в том, что некоторые нейроны оказываются незадействованными. Это проявляется в том, что нейроны, имеющие начальные весовые векторы, значительно удаленные от векторов входа, никогда Соответствующее правило настройки, учитывающее нечувствительность мертвых нейронов, реализовано в виде М-функции learncon и заключается в следующем. В начале процедуры настройки всем нейронам конкурирующего слоя присваивается одинаковый параметр активности

где N – количество нейронов конкурирующего слоя, равное числу кластеров. В процессе настройки М-функция learncon корректирует этот параметр таким образом, чтобы его значения для активных нейронов становились больше, а для неактивных нейронов меньше. Соответствующая формула для вектора приращений параметров активности выглядит следующим образом:

где lr – параметр скорости настройки; Нетрудно убедиться, что для всех нейронов, кроме нейрона-победителя, приращения отрицательны. Поскольку параметры активности связаны со смещениями соотношением (в обозначениях системы MATLAB)

то из этого следует, что смещение для нейрона-победителя уменьшится, а смещения для остальных нейронов немного увеличатся. М-функция learncon использует следующую формулу для расчета приращений вектора смещений

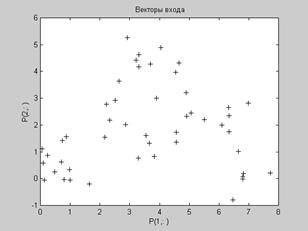

Параметр скорости настройки lr по умолчанию равен 0.001, и его величина обычно на порядок меньше соответствующего значения для М-функции learnk. Увеличение смещений для неактивных нейронов позволяет расширить диапазон покрытия входных значений, и неактивный нейрон начинает формировать кластер. В конечном счете он может начать притягивать новые входные векторы. Это дает два преимущества. Если нейрон не выигрывает конкуренции, потому что его вектор весов существенно отличается от векторов, поступающих на вход сети, то его смещение по мере обучения становится достаточно большим и он становится конкурентоспособным. Когда это происходит, его вектор весов начинает приближаться к некоторой группе векторов входа. Как только нейрон начинает побеждать, его смещение начинает уменьшаться. Таким образом, задача активизации "мертвых" нейронов оказывается решенной. Второе преимущество, связанное с настройкой смещений, состоит в том, что они позволяют выравнять значения параметра активности и обеспечить притяжение приблизительно одинакового количества векторов входа. Таким образом, если один из кластеров притягивает большее число векторов входа, чем другой, то более заполненная область притянет дополнительное количество нейронов и будет поделена на меньшие по размерам кластеры. Обучение сети Реализуем 10 циклов обучения. Для этого можно использовать функции train или adapt: net.trainParam.epochs = 10; net = train(net,p); net.adaptParam.passes = 10; [net,y,e] = adapt(net,mat2cell(p)); Заметим, что для сетей с конкурирующим слоем по умолчанию используется обучающая функция trainwb1, которая на каждом цикле обучения случайно выбирает входной вектор Выполним моделирование сети после обучения: a = sim(net,p); ac = vec2ind(a) ac = 2 1 2 1 Видим, что сеть обучена классификации векторов входа на 2 кластера: первый расположен в окрестности вектора (0, 0), второй – в окрестности вектора (1, 1). Результирующие веса и смещения равны: wts1 = net.IW{1,1} b1 = net.b{1} wts1 = 0.58383 0.58307 0.41712 0.42789 b1 = 5.4152 5.4581 Заметим, что первая строка весовой матрицы действительно близка к вектору (1, 1), Пример: Функционирование слоя Кохонена можно пояснить более наглядно, используя графику системы MATLAB. Рассмотрим 48 случайных векторов на плоскости, формирующих 8 кластеров, группирующихся около своих центров. На графике, приведенном на рис. 7.3, показано 48 двухэлементных векторов входа. Сформируем координаты случайных точек и построим план их расположения c = 8; n = 6; % Число кластеров, векторов в кластере d = 0.5; % Среднеквадратичное отклонение от центра кластера x = [–10 10;–5 5]; % Диапазон входных значений [r,q] = size(x); minv = min(x')'; maxv = max(x')'; v = rand(r,c).*((maxv – minv)*ones(1,c) + minv*ones(1,c)); t = c*n; % Число точек v = [v v v v v v]; v=v+randn(r,t)*d; % Координаты точек P = v; plot(P(1,:), P(2,:),'+k') % Рис.7.3 title(' Векторы входа'), xlabel('P(1,:)'), ylabel('P(2,:)') Векторы входа, показанные на рис. 7.3, относятся к различным классам.

Применим конкурирующую сеть из восьми нейронов для того, чтобы распределить их по классам: net = newc([–2 12;–1 6], 8 ,0.1); w0 = net.IW{1} b0 = net.b{1} c0 = exp(1)./b0 Начальные значения весов, смещений и параметров активности нейронов представлены в следующей таблице:

После обучения в течение 500 циклов получим: net.trainParam.epochs = 500; net = train(net,P); w = net.IW{1} bn = net.b{1} cn = exp(1)./bn

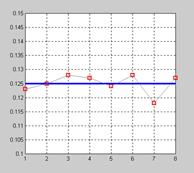

Как следует из приведенных таблиц, центры кластеризации распределились по восьми областям, показанным на рис. 7.4, а; смещения отклонились в обе стороны от исходного значения 21.746 так же, как и параметры активности нейронов, показанные на рис. 7.4, б.

Рис. 7.4 Рассмотренная самонастраивающаяся сеть Кохонена является типичным примером сети, которая реализует процедуру обучения без учителя. Демонстрационный пример democ1 также поясняет процедуру обучения самоорганизующейся сети. Карта Кохонена Самоорганизующаяся сеть в виде карты Кохонена предназначена для решения задач кластеризации входных векторов. В отличие от слоя Кохонена карта Кохонена поддерживает такое топологическое свойство, когда близким кластерам входных векторов соответствуют близко расположенные нейроны. Первоначальная топология размещения нейронов в слое Кохонена задается М-функциями gridtop, hextop или randtop, что соответствует размещению нейронов в узлах либо прямоугольной, либо гексагональной сетки, либо в узлах сетки со случайной топологией. Расстояния между нейронами вычисляются с помощью специальных функций вычисления расстояний dist, boxdist, linkdist и mandist. Карта Кохонена для определения нейрона-победителя использует ту же процедуру, какая применяется и в слое Кохонена. Однако на карте Кохонена одновременно изменяются весовые коэффициенты соседних нейронов в соответствии со следующим соотношением, именуемым правилом Кохонена:

В этом случае окрестность нейрона-победителя включает все нейроны, которые находятся в пределах некоторого радиуса d:

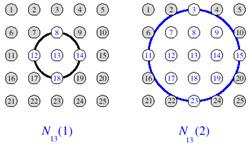

Чтобы пояснить понятие окрестности нейрона, обратимся к рис. 7.5.

Левая часть рисунка соответствует окрестности радиуса 1 для нейрона-победителя

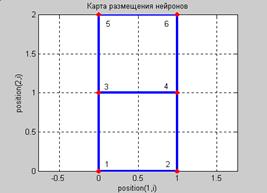

Заметим, что топология карты расположения нейронов не обязательно должна быть двумерной. Это могут быть и одномерные и трехмерные карты, и даже карты больших размерностей. В случае одномерной карты Кохонена, когда нейроны расположены вдоль линии, каждый нейрон будет иметь только двух соседей в пределах радиуса 1 или единственного соседа, если нейрон расположен на конце линии. Расстояния между нейронами можно определять различными способами, используя прямоугольные или гексагональные сетки, однако это никак не влияет на характеристики сети, связанные с классификацией входных векторов. Топология карты Как уже отмечалось выше, можно задать различные топологии для карты расположения нейронов, используя М-функции gridtop, hextop, randtop. Рассмотрим простейшую прямоугольную сетку размера 2´3 для размещения шести нейронов, которая может быть сформирована с помощью функции gridtop: pos = gridtop(2,3) pos = 0 1 0 1 0 1 0 0 1 1 2 2 plotsom(pos) % Рис.7.6 Соответствующая сетка показана на рис. 7.6. Метки position(1, i) и position(2, i) вдоль координатных осей генерируются функцией plotsom и задают позиции расположения нейронов по первой, второй и т. д. размерностям карты.

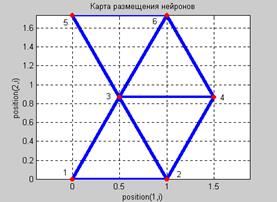

Здесь нейрон 1 расположен в точке с координатами (0,0), нейрон 2 – в точке (1,0), нейрон 3 – в точке (0,1) и т. д. Заметим, что, если применить команду gridtop, переставив аргументы местами, получим иное размещение нейронов: pos = gridtop(3,2) pos = 0 1 2 0 1 2 0 0 0 1 1 1 Гексагональную сетку можно сформировать с помощью функции hextop: pos = hextop(2,3) pos = 0 1.0000 0.5000 1.5000 0 1.0000 0 0 0.8660 0.8660 1.7321 1.7321 plotsom(pos) % Рис.7.7

Заметим, что М-функция hextop используется по умолчанию при создании карт Кохонена при применении функции newsom. Сетка со случайным расположением узлов может быть создана с помощью функции randtop: pos = randtop(2,3) pos = 0.061787 0.64701 0.40855 0.94983 0 0.65113 0 0.12233 0.90438 0.54745 1.4015 1.5682 plotsom(pos) % Рис.7.8

Не нашли, что искали? Воспользуйтесь поиском по сайту: ©2015 - 2026 stydopedia.ru Все материалы защищены законодательством РФ.

|

, (7.3)

, (7.3) , (7.4)

, (7.4) – вектор, элемент i* которого равен 1, а остальные – 0.

– вектор, элемент i* которого равен 1, а остальные – 0. , (7.5)

, (7.5) . (7.6)

. (7.6) Рис. 7.3

Рис. 7.3 а

а

б

б

(7.7)

(7.7) (7.8)

(7.8) Рис. 7.5

Рис. 7.5 (7.9)

(7.9) Рис. 7.6

Рис. 7.6 Рис. 7.7

Рис. 7.7 Рис. 7.8

Рис. 7.8